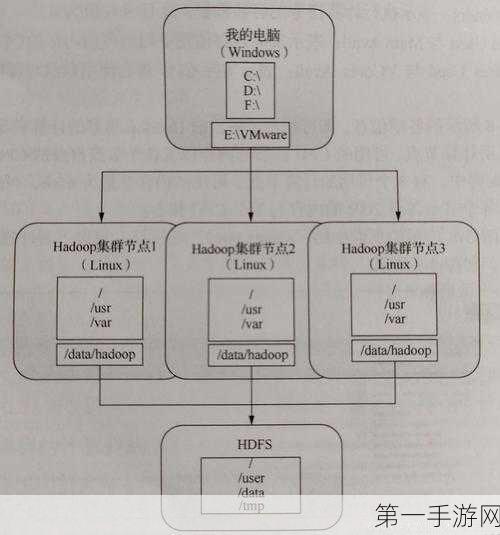

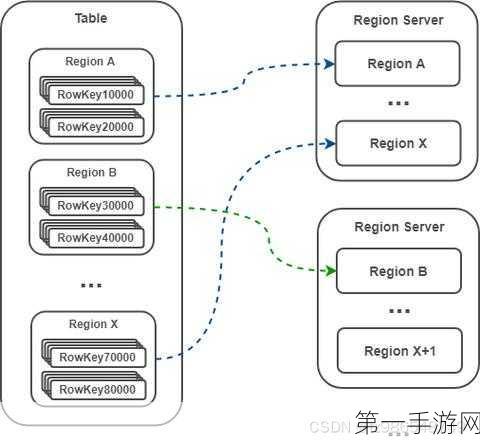

在大数据的浪潮中,HDFS(Hadoop Distributed File System)与HBase作为Hadoop生态系统中的两大核心组件,分别承担着数据存储与高效随机访问的重任,随着企业对数据迁移需求的日益增长,如何实现HDFS与HBase跨集群的数据迁移,成为了众多开发者关注的焦点,我们将深入探索一套实战源码,揭秘这一技术难题的解决方案,带你领略数据迁移的奥秘!🚀

在大数据的世界里,数据的流动如同血液在人体中的循环,至关重要,HDFS以其高容错性和高吞吐量的特点,成为了大数据存储的首选方案,而HBase,则以其基于列的存储模型和对海量数据的实时读写能力,在大数据处理中占据了举足轻重的地位,当企业面临业务扩张或数据中心迁移等场景时,如何高效、安全地将HDFS与HBase中的数据从一个集群迁移到另一个集群,成为了一个亟待解决的问题。🤔

为了解决这一难题,我们精心准备了一套实战源码,旨在帮助开发者快速掌握HDFS与HBase跨集群数据迁移的核心技术,这套源码不仅包含了详细的数据迁移流程,还涵盖了数据校验、异常处理、性能优化等多个方面,确保数据迁移的准确性和高效性。📝

在源码的实战过程中,我们首先会遇到数据迁移的准备工作,这包括确定迁移的数据范围、评估迁移的数据量、配置源集群和目标集群的网络环境等,这些看似简单的步骤,却是确保数据迁移顺利进行的基础。📋

源码将展示如何编写数据迁移的脚本,这些脚本将利用HDFS和HBase提供的API,实现数据的读取、转换和写入操作,在编写脚本的过程中,我们需要注意数据的格式转换、字段的映射以及数据的去重等问题,以确保数据在迁移过程中的完整性和一致性。📝💻

在数据迁移的过程中,性能优化是一个不可忽视的环节,源码中提供了多种优化策略,如批量处理、多线程并发、数据压缩等,以提高数据迁移的速度和效率,源码还包含了数据迁移过程中的异常处理机制,确保在出现错误时能够及时定位问题并采取相应的补救措施。🚀🔧

除了技术层面的实现,源码还强调了数据迁移过程中的安全性和可靠性,通过配置SSL加密、设置访问控制列表等措施,确保数据在迁移过程中的安全性,源码还提供了数据迁移的日志记录和监控功能,以便在迁移过程中实时了解数据的迁移进度和状态。🔒📊

值得一提的是,这套实战源码不仅适用于HDFS与HBase之间的跨集群数据迁移,还可以扩展到其他大数据存储系统之间的数据迁移,通过灵活配置和扩展,可以满足不同场景下的数据迁移需求。🔧🌐

在实战源码的最后部分,我们还提供了详细的测试案例和性能评估报告,这些测试案例涵盖了不同数据量、不同网络环境、不同硬件配置下的数据迁移场景,为开发者提供了丰富的参考数据,性能评估报告也揭示了数据迁移过程中的瓶颈和潜在优化点,为后续的性能优化提供了有力的支持。📊📈

这套HDFS与HBase跨集群数据迁移实战源码不仅是一套技术解决方案,更是一套完整的数据迁移方法论,它涵盖了数据迁移的准备工作、脚本编写、性能优化、安全性和可靠性等多个方面,为开发者提供了全方位的技术支持和指导,无论你是大数据领域的初学者还是资深专家,都能从中受益匪浅。🎉💡