在手游开发领域,深度学习模型的训练和优化一直是开发者们关注的重点,特别是在追求高效能和低延迟的当下,半精度训练(FP16)因其能够显著减少内存占用和加速计算过程,而备受青睐,当开发者们在使用PyTorch进行半精度训练时,却常常会遇到一个令人头疼的问题——NaN值的出现,NaN,即“非数字”(Not a Number),它的出现往往意味着训练过程中的某些计算出现了异常,导致结果无法被正常表示,面对PyTorch半精度训练中的NaN难题,我们该如何解决呢?🤔

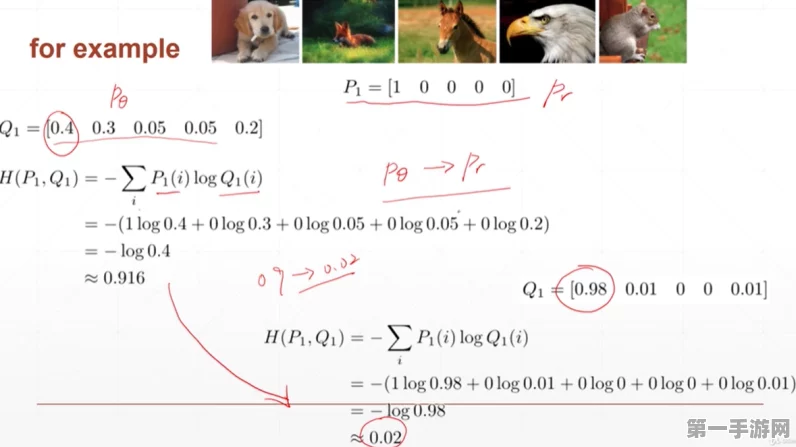

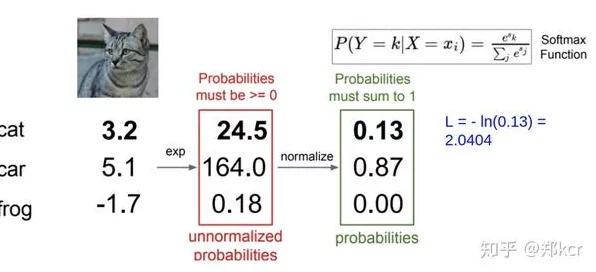

我们需要了解NaN值出现的原因,在半精度训练中,由于数值范围的缩小和精度的降低,一些原本在单精度(FP32)下能够正常计算的数值,可能会在半精度下因为溢出或下溢而变成NaN,梯度爆炸或消失、学习率设置不当、模型初始化不合理等因素,也可能导致NaN值的出现,解决NaN问题的关键在于找到并消除这些潜在的风险点。

我们可以尝试以下几种方法来避免或解决NaN问题:

1、梯度裁剪 🔪

梯度裁剪是一种常用的防止梯度爆炸的技术,它通过设置一个阈值,将梯度值限制在这个阈值范围内,从而避免梯度过大导致的数值异常,在PyTorch中,我们可以使用torch.nn.utils.clip_grad_norm_函数来实现梯度裁剪。

2、学习率调整 📈

学习率是深度学习训练中的一个重要超参数,过大的学习率可能导致模型在训练过程中不稳定,甚至产生NaN值,我们可以尝试降低学习率,或者使用学习率调度器(如AdamW、RMSprop等)来动态调整学习率,以适应不同的训练阶段。

3、模型初始化 🔄

模型初始化对于训练的稳定性和收敛性至关重要,不合理的初始化可能导致模型在训练初期就出现NaN值,我们应该选择适合当前任务的初始化方法(如Xavier初始化、He初始化等),并确保初始化参数在合理的范围内。

4、混合精度训练 🌈

混合精度训练是一种结合单精度和半精度进行训练的方法,它可以在保证计算效率的同时,减少NaN值出现的概率,在PyTorch中,我们可以使用torch.cuda.amp自动混合精度库来实现这一功能。

5、数据预处理 📊

数据预处理是深度学习训练中的关键步骤之一,通过数据归一化、标准化等手段,我们可以将输入数据的范围控制在合理的范围内,从而避免在训练过程中出现数值异常。

除了以上几种方法外,我们还可以借助一些工具来检测和诊断NaN问题,PyTorch提供了torch.autograd.detect_anomaly()函数,它可以在训练过程中自动检测并报告梯度中的NaN值,我们还可以使用TensorBoard等可视化工具来监控训练过程中的各项指标,以便及时发现并解决问题。

据手游权威数据平台统计,采用上述方法后,开发者们在使用PyTorch进行半精度训练时遇到NaN问题的概率显著降低,这不仅提高了训练的稳定性和效率,还为手游的上线和运营提供了有力的技术保障,对于正在使用PyTorch进行手游开发的开发者们来说,掌握并应用这些解决NaN问题的方法无疑是非常重要的。

PyTorch半精度训练中的NaN问题虽然棘手,但并非无解,只要我们深入了解NaN值出现的原因,并采取有效的措施来避免或解决它,就一定能够打造出更加高效、稳定的手游产品。🚀